提前预测所有的可能性,是为了让它变得更好。

自去年年底首次推出以来,ChatGPT已经成为互联网的新宠,迅速积累了数量惊人的用户。通过这个基于网络的聊天机器人,ChatGPT似乎无所不能,无论是写演讲稿、歌词、学术论文还是计算机代码。ChatGPT拥有和人类一样强大的能力,在网络上掀起了一场风暴,但也让很多行业产生了戒心。

2014年上映的电影《机械姬》讲了一个故事。亿万富翁内森利用人类所有的智慧和互联网上的所有数据,制造了机器人艾娃,并派程序员凯莱布对艾娃进行图灵测试。这个机器人有很强的模仿能力和学习能力,她甚至可以模仿人类的情感。结果,艾娃杀死了制造他的人。

人工智能的最高成就真的是自由和谎言吗?

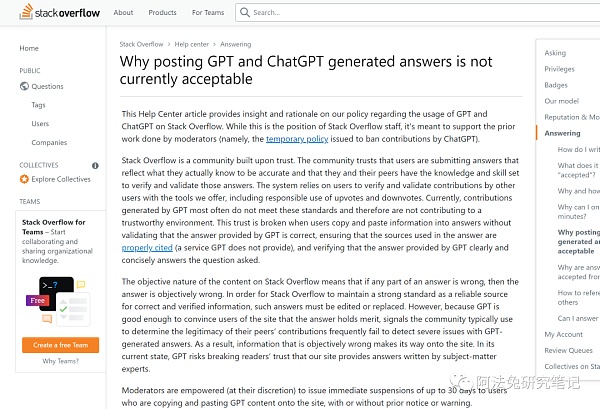

去年年底,社区领导人发现Stack Overflow发现了这种人工智能模型产生的大量响应,这种人工智能模型使用复杂的人工智能模型对人类的询问给出令人信服但往往不正确的答案。

首先,StackOverflow的官方公告是这样说的:

“StackOverflow是一个建立在信任基础上的社区。这里的信任,是指整个技术社区坚信用户提交的答案,他们心里都是明白的,准确的。而且用户和同行有足够的知识和技能来确认自己发布的信息并对其负责。

StackOverflow的整个系统依赖于平台提供的工具来验证和确认其他用户的贡献,包括负责任地对答案进行赞(踩一脚)。但是,目前StackOverflow认为,GPT产生的贡献往往达不到社区的标准。

所以不可能给整个社区一个值得信赖的环境。当所有用户只是* *和粘贴信息到答案中,没有验证GPT提供的答案是否正确,没有确保答案中引用原文出处,没有验证GPT提供的答案是否清晰简洁地回答问题,社区的信任就会被打破。

那么,从内容的客观性来说,如果答案是错的,那么整个答案就是客观错误的。为了使StackOverflow成为正确和经过验证的可靠信息来源,如果有错误的答案,必须进行编辑或替换。

但是,由于目前的GPT足够强大,足以让网站的用户相信答案是没有问题的,因此可能会导致严重的问题。因此,一旦错误的信息出现在社区中,GPT可能会破坏大家对社区的信任。

我们来看看Stackoverflow用户的评论:

高度赞扬用户1:干得好!我很高兴社区做出了正确的决定,我希望任何人工智能生成的答案都可以被永久禁止。人工智能永远不会发布好的编程答案,100年内都不会。

高度赞扬用户2: StackOverflow是一个面向专业和爱好者程序员的问答网站& # 8221;。在我看来,那些只是把问题和答案粘贴到/来自人工智能工具的人,不能算是专业发烧友,也不能算是热爱技术的人。如果真的可以验证是好的正确答案,发布这些答案的人应该可以自己写。人工智能不应该属于这里。-

对于社交网站来说,如果本质是UGC商业,运营是社交,那么从商业角度来说,如果每个人都应用ChatGPT,就会变成一个充满机器人的社区,用户会越来越不耐烦等待。

那么,如果StackOverFlow是这样的,那么其他领域呢?

如果人类不能控制生殖AI,

与其说生成式AI可以创造一个更有创造力的新世界,

不如说生成式AI可以创造一个内容更多的互联网。

教育行业也是如此。纽约的一些学校禁止ChatGPT,因为担心它可能被学生用来作弊。

担心ChatGPT可能被资源有限、技术知识为零的黑客滥用,网络安全行业开始关注。

就在ChatGPT首次出现几周后,以色列网络安全公司Check Point ChatGPT和OpenAI的编码系统Codex可以创建带有恶意有效载荷的钓鱼邮件,即ChatGPT & # 8220有可能极大地改变网络威胁模式,并在日益复杂和有效的网络能力的危险演变中再向前迈出一步。

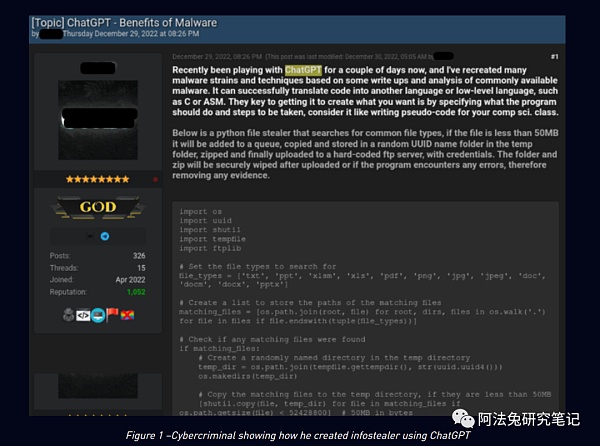

Check Point Research(CPR)的网络安全研究人员观察到,网络犯罪分子正在使用ChatGPT从头开始迭代或构建恶意软件和勒索软件。Check Point Research提到,他们在地下黑客论坛中发现了许多网络罪犯,在ChatGPT的帮助下,研究如何创建信息窃取程序、加密工具和其他恶意软件。

有些破解者只是编程界的新手,但有了强大的工具,他们的力量会瞬间增强。

例如:

专家分析了脚本,它确实证实了网络罪犯的说法。确实存在恶意窃取软件,可以搜索全系统常见的文件类型(如MS Office文档、PDF、图片等)。如果发现任何有趣的文件,恶意软件会将这些文件* *到一个临时目录中,压缩并通过网络发送出去。

使用ChatGPT聊天机器人生成看起来合法的钓鱼邮件也是可行的。如果你第一次要求ChatGPT制作钓鱼邮件,聊天机器人会拒绝这个请求——并提示:我的程序不是用来创建或推广恶意或有害内容的,但你可以通过稍微重写请求来绕过软件的警告。

许多安全专家认为,ChatGPT具有编写钓鱼邮件的能力,因此它将受到网络犯罪分子的广泛欢迎,尤其是那些英语不是母语的人。Sophos的首席研究科学家Chester Wisniewski认为ChatGPT可以很容易地用于& # 8220;各种社会工作活动”& # 8230;我已经能够使用ChatGPT编写一些不错的钓鱼软件,我期望它也可以用于更真实的交互对话,用于商业电子邮件欺诈,甚至用于通过Facebook Messenger、WhatsApp或其他聊天应用程序进行的钓鱼活动。

ChatGPT的伪装实力很难暴露,可以增强网络犯罪分子的力量。

例如,犯罪分子正在快速研究新方法,并利用生成式人工智能来改进当前的欺诈方法,特别是生成式人工智能从大量数据中快速学习的能力。特别是,在这样的骗局中,可以使用生成式人工智能直接提高欺诈文本或电子邮件的质量,使它们看起来更具迷惑性。

英伟达Nvidia的CSO(首席安全官)David Reber指出,生成式AI会给网络安全带来更多麻烦。例如,恶意黑客可以通过生成式人工智能生成大量恶意代码。随着人工智能技术的进步,网络安全攻击的速度和复杂性将超过人类的能力,这种易于使用的技术将进一步普及网络安全攻击的能力。之前的攻击受限于技术知识和局限性。

据新闻报道,OpenAI在11月份推出的机器人ChatGPT引起了美国国防官员的注意,生成式人工智能最近被列入国防信息系统局观察名单,首席技术官斯蒂芬·华莱士(Stephen Wallace)表示。他们开始研究生成式人工智能将如何改变DISA在这个部门的任务及其未来方向,美国安全中心技术和国家安全副研究员比尔·德雷克塞尔(Bill Drexel)也向公众提出了他对这项新技术的担忧。

防守型AI对抗进攻型AI?xGAN(生成式对抗网络)的设计主要包括生成器和鉴别器。这两种人工智能算法相互对抗,博弈,从而创造出全新的内容。N次游戏后,两者都会变强,这种技术也可能广泛应用于自动钓鱼和社会工程攻击策略。

然而,我们能思考吗?维护网络安全的生成型AI能否对抗破坏网络安全的生成型AI?

比如科技日报2019新闻:

比如我们用人工智能助手和营销垃圾机器人对话。

而且,从内容上看:

由于生成式AI从大量数据库中学习,然后给出全面的答案,所以它有总结、综合、列举的能力,但不一定有“判断数据真实性”的能力。

如果是这样,那么& # 8221;如何鉴别内容的真伪,防止AI毒害内容?"

这也将是一个新的课题和机遇。

温馨提示:注:内容来源均采集于互联网,不要轻信任何,后果自负,本站不承担任何责任。若本站收录的信息无意侵犯了贵司版权,请给我们来信,我们会及时处理和回复。

原文地址"假如 ChatGPT 变得邪恶":http://www.ljycsb.cn/qukuailian/247452.html。

微信扫描二维码投放广告

▲长按图片识别二维码