关于ZKML: ZKML(零知识机器学习)是一种机器学习技术,结合了零知识证明和机器学习算法,解决了机器学习中的隐私保护问题。

关于分布式计算能力:分布式计算能力是指将一个计算任务分解成多个小任务,并将这些小任务分配给多个计算机或处理器进行处理,从而实现高效计算。

AI和Web3的现状:失控的蜂群和熵增

在《失控:机器、社会和经济的新生物学》中,凯文·凯利曾提出一个现象:蜂群会按照分布式管理,以群舞的形式进行选举决策,整个蜂群会跟随这个群舞中最大的蜂群成为一个事件的主宰。这也是莫里斯·梅特林克所说的所谓“蜂群之魂”——每只蜜蜂都可以自己做出决定,并引导其他蜜蜂去确认,最后的决定真的是群体选择。

熵增无序定律本身遵循热力学定律,物理上的理论具体化就是把一定数量的分子放入空 box,计算出最终的分布。就人而言,算法生成的mob即使存在个体思维差异,也能表现出群体规律,而且往往会因时代等因素而局限于a 空 box,最终会做出一致的决策。

当然,群体法则不一定正确,但一个能代表共识,能自己建立共识的意见领袖,是绝对的超个人。但多数情况下,共识并不追求所有人的完全无条件同意,只需要群体的普遍认同。

我们在这里不是讨论AI会不会把人类引入歧途。其实这样的讨论很多,无论是人工智能应用产生的大量垃圾已经污染了网络数据的真实性,还是因为群体决策失误导致某些事件会走向更危险的境地。

AI的现状有着天然的垄断性。比如大模型的训练和部署,需要大量的计算资源和数据,只有少部分企事业单位具备这些条件。这上亿的数据被每一个垄断者奉为至宝,别说开源共享,连相互访问都不可能。

这就带来了数据的极大浪费。每一个大规模的AI项目,都需要反复收集用户数据,最后赢家通吃——无论是并购还是出售,扩张单个巨头项目,还是传统互联网圈地的逻辑。

很多人说AI和Web3是两回事,互不相干——前半段是对的,这是两条不同的赛道,后半段却有问题。用分布式技术限制人工智能的垄断,用人工智能技术促进去中心化共识机制的形成,这是很自然的。

底层推演:让AI形成真正的分布式群体共识机制

人工智能的核心还是在于人本身,机器和模型只是对人思维的推测和模仿。所谓群体,其实很难把群体抽象出来,因为你每天看到的还是一个真实的个体。但模型是利用海量数据进行学习和调整,最终模拟群体形态。不评价这种模式会带来什么样的结果,因为群恶事件不是一次两次发生的。但是这个模型恰恰代表了这种共识机制的出现。

比如对于一个具体的道,如果把治理做成一种机制,必然会对效率产生影响,因为群体共识的形成是一件麻烦的事情,更不用说投票、统计等一系列操作了。如果道的治理以AI模型的形式体现,所有的数据采集都来自道中每个人的言语数据,那么输出的决策其实会更接近群体共识。

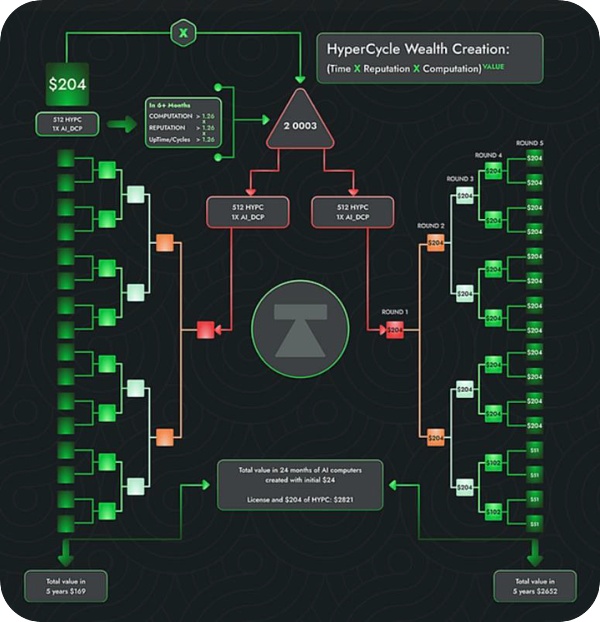

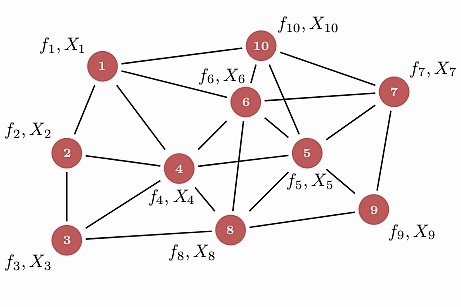

单一模型的群体共识可以按照上述方案进行训练,但对这些个体来说毕竟还是一个孤岛。如果有一个集体智能系统来组成一个群体AI,在这个系统中,各个AI模型会协同工作来解决复杂的问题,这其实对共识层面的赋能有很大的作用。

对于小型集合,既可以独立构建生态,也可以与其他集合形成协作集,更高效、低成本地满足超大型计算能力或数据事务。但是问题又来了。各种模型数据库之间的现状是对他人完全不信任和警惕——这是区块链的天然属性:通过不信任,真正分布式的AI机器可以安全高效地交互。

一个全局智能大脑可以让原本独立的、单一功能的AI算法模型相互协作,在内部执行复杂的智能算法过程,从而形成分布式的群体共识网络。这也是AI赋能Web3的最大意义。

隐私和数据垄断?ZK和机器学习的结合

人类对AI是否邪恶,基于对隐私的保护和对数据垄断的恐惧,必须采取针对性的防范措施。核心问题是我们不知道如何得出结论。同样,模型的操作者也不打算回答这个问题。对于上面提到的全球智能大脑的组合,就更需要解决这个问题了,否则没有一个数据方愿意拿出自己的核心和别人分享。

ZKML(零知识机器学习)是一种将零知识证明应用于机器学习的技术。零知识证明(ZKP),即证明者可以在不公开具体数据的情况下说服验证者数据的真实性。

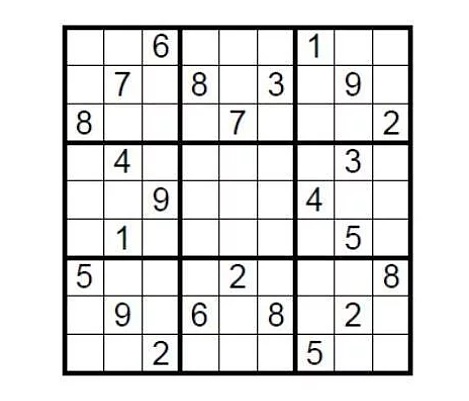

基于理论案例。有一个9×9的标准数独,完成条件是你需要在9个方块中填入1到9的数字,这样每个数字在每一行、每一列、每9个方块中只能出现一次。那么安排这个谜题的人如何在不透露答案的情况下向挑战者证明数独有解呢?

只需用答案覆盖填充,然后随机让挑战者取几行或几列,将所有数字打乱,验证是否都是一到九。这是一个简单的零知识证明实施例。

零知识证明技术有三个特点:完备性、正确性和零知识,即证明结论时不透露任何细节。其技术来源可以体现简单性。在同态加密的背景下,验证的难度远低于生成证明的难度。

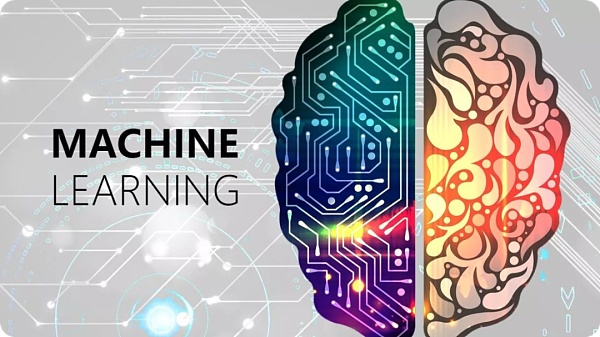

机器学习使用算法和模型来使计算机系统从数据中学习和改进。通过自动学习经验,系统可以根据数据和模型自动执行预测、分类、聚类和优化等任务。

机器学习的核心是建立模型,可以从数据中学习,自动做出预测和决策。这些模型的构建通常需要三个关键要素:数据集、算法和模型评估。数据集是机器学习的基础,它包含用于训练和测试机器学习模型的数据样本。算法是机器学习模型的核心,它定义了模型如何从数据中学习和预测。模型评估是机器学习的重要组成部分,用于评估模型的性能和准确性,决定是否有必要对模型进行优化和改进。

在传统的机器学习中,通常需要在一个集中的地方收集数据集进行训练,这意味着数据所有者必须将数据共享给第三方,这可能会导致数据泄露或隐私泄露的风险。使用ZKML,数据所有者可以在不泄露数据的情况下与他人共享数据集,这是通过使用零知识证明实现的。

当零知识证明应用于机器学习的赋能时,效果应该是可预期的,解决了长期存在的隐私黑箱和数据垄断问题:项目方能否在不泄露用户数据输入或模型的具体细节的情况下完成证明和验证,各套能否共享自己的数据或模型发挥作用而不泄露隐私数据?当然现在的技术还早,实践中肯定会有很多问题,这并不妨碍我们的想象,很多团队已经在开发了。

这种情况会把小数据库的白嫖带到大数据库吗?当你想到治理时,你会回到我们对Web3的思考。Crypto的本质在于治理。无论是通过大量的应用,还是分享,都应该获得应有的动力。无论是通过原有的Pow、PoS机制还是最新的PoR(信誉证明机制),都是为了保证激励效果。

分布式计算能力:谎言与现实交织的创新叙事

分布式计算网络一直是加密界的热门话题。毕竟AI大模型需要惊人的计算能力,集中式的计算网络不仅浪费资源还会形成虚拟垄断——如果最后是GPU的数量,那就太没意思了。

分布式计算网络的本质是整合分散在不同地方、不同设备上的计算资源。人们经常提到的主要优势是:提供分布式计算能力,解决隐私问题,增强人工智能模型的可信度和可靠性,支持各种应用场景下的快速部署和运行,提供去中心化的数据存储和管理解决方案。是的,通过分散计算能力,任何人都可以运行AI模型,并在来自全球用户的真实数据集上进行测试,从而享受到更加灵活、高效和低成本的计算服务。

同时,分布式计算可以通过创建一个强大的框架来解决隐私问题,保护用户数据的安全和隐私。还提供了透明、可验证的计算过程,增强了人工智能模型的可信度和可靠性,为各种应用场景下的快速部署和运行提供了灵活、可扩展的计算资源。

我们从一个完整的集中计算过程来看模型训练,步骤通常分为:数据准备、数据分割、设备间数据传输、并行训练、梯度聚合、参数更新、同步,然后重复训练。在这个过程中,即使集中式机房使用高性能计算设备集群,通过高速网络连接共享计算任务,高昂的通信成本也成为了分布式计算网络的最大局限之一。

所以,虽然去中心化的计算网络有很多优势和潜力,但是按照目前的通信成本和实际操作难度来看,发展道路还是曲折的。在实践中,分布式计算网络的实现需要克服许多实际的技术问题,无论是如何保证节点的可靠性和安全性,如何有效地管理和调度分散的计算资源,还是如何实现高效的数据传输和通信等。,恐怕是实践中的大问题。

尾巴:对理想主义者的期望

回归商业现实,AI与Web3深度结合的叙事看起来是那么美好,但资本和用户更多的是用实际行动告诉我们,这注定是一场异常艰难的创新之旅。除非该项目能够在像OpenAI一样强大的同时拥抱一个强大的财务所有者,否则无底洞的R&D费用和不清晰的商业模式将彻底压垮我们。

AI和Web3现在都处于极其早期的发展阶段,就像上世纪末的互联网泡沫一样,直到近十年后才正式迎来真正的黄金时代。麦卡锡梦想在一个假期内设计出具有人类智能的人工智能,但直到近七十年后,我们才真正迈出了人工智能的关键一步。

Web3+AI也是如此。我们已经确定了前进道路的正确性,剩下的就交给时间吧。

当时间的潮水渐渐退去,那些静止不动的人和事,就是我们从科幻走向现实的基石。

温馨提示:注:内容来源均采集于互联网,不要轻信任何,后果自负,本站不承担任何责任。若本站收录的信息无意侵犯了贵司版权,请给我们来信,我们会及时处理和回复。

原文地址"分布式计算引擎,分布式zk的使用":http://www.ljycsb.cn/qukuailian/212610.html。

微信扫描二维码投放广告

▲长按图片识别二维码