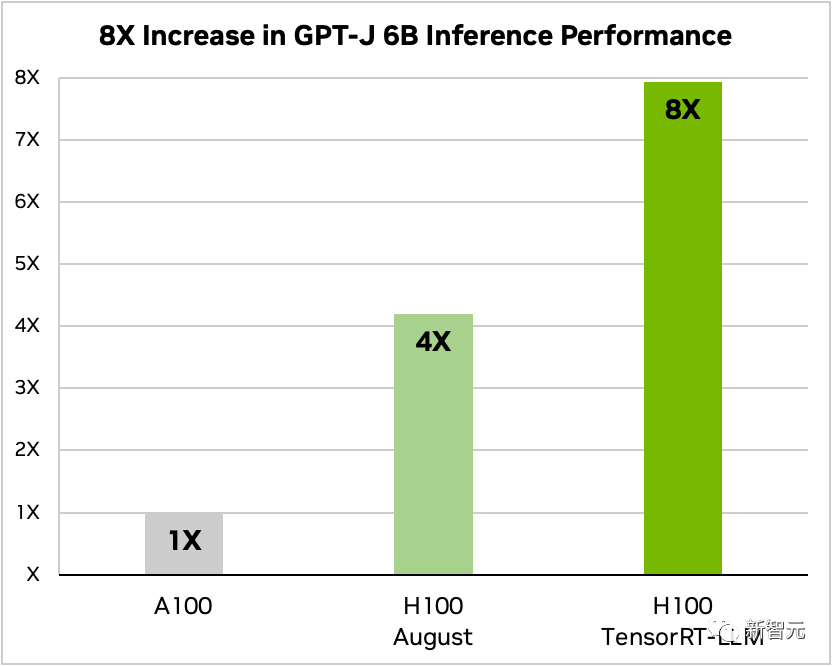

就在刚刚,NVIDIA发布了一款开源软件TensorRT-LLM,可以在H100上加速大型语言模型的推理。

那么,能提高多少倍呢?在加入TensorRT-LLM和一系列优化功能(包括飞行中批处理)后,模型的总吞吐量提高了8倍。

GPT-J-6B100和H100有无TensorRT-LLM的对比另外,以Llama 2为例,TensorRT-LLM比单独使用A100推理性能提高了4.6倍。

对比有无TensorRT-LLM的LLAM270B、A100、H100,网友表示,超级H100结合TensorRT-LLM,无疑将彻底改变大规模语言模型的推理现状!

TensorRT-LLM:大规模模型推理加速神器目前,由于大模型的参数规模巨大,“部署和推理”的难度和成本居高不下。

TensorRT-LLM:大规模模型推理加速神器目前,由于大模型的参数规模巨大,“部署和推理”的难度和成本居高不下。

NVIDIA开发的TensorRT-LLM旨在通过GPU显著提高LLM吞吐量并降低成本。

具体来说,TensorRT-LLM将TensorRT的深度学习编译器、FasterTransformer的优化内核、预处理和后处理、多GPU/多节点通信封装在一个简单的开源Python API中。

Nvidia进一步增强了FasterTransformer,使其成为面向产品的解决方案。

可以看出,TensorRT-LLM提供了一个易用、开源、模块化的Python应用编程接口。

码农不需要深厚的C++或CUDA专业知识,就能部署、运行、调试各种大型语言模型,还能获得顶级性能和快速定制。

根据英伟达的官方博客,TensorRT-LLM从四个方面优化了英伟达GPU上的LLM推理性能。

首先,TensorRT-LLM是针对目前的10+大模型推出的,方便开发者即时运行。

其次,TensorRT-LLM作为开源软件库,允许LLM同时在多个GPU和多个GPU服务器上推理。

这些服务器分别通过英伟达的NVLink和InfiniBand互联。

三是“In-flight batch processing”,这是一种全新的调度技术,允许不同型号的任务独立于其他任务进出GPU。

最后,对TensorRT-LLM进行了优化,可以使用H100 Transformer引擎来减少模型推理中的内存占用和延迟。

接下来,我们具体看看TensorRT-LLM是如何提高模型性能的。

TensorRT-LLM,支持丰富的LLM生态,为开源模型生态提供了非常好的支持。最大最先进的语言模型,如Meta推出的Llama 2-70B,需要多个GPU协同工作,提供实时响应。此前,如果想要实现LLM推理的最佳性能,开发者必须重写AI模型,手动将其拆分成多个片段,并协调GPU之间的执行。

TensorRT-LLM采用张量并行技术(tensor paralleli)将权重矩阵分配给各个设备,从而简化这一过程,实现大规模高效推理。

每个模型都可以在通过NVLink连接的多个GPU和多个服务器上并行运行,无需开发人员干预或模型更改。

随着新模型和模型架构的引入,开发者可以在TensorRT-LLM中使用最新的NVIDIA AI Kernal来优化模型。

支持内核融合,包括在GPT模型的执行上下文和生成阶段使用的最先进的FlashAttention实现和mask多头注意。

此外,TensorRT-LLM还包括许多流行的大型语言模型的完全优化和立即可操作的版本。

包括Meta Llama 2、OpenAI GPT-2、GPT-3、猎鹰、马赛克MPT、BLOOM等10多个型号。所有这些模型都可以通过使用易于使用的TensorRT-LLM Python API来调用。

这些功能可以帮助开发者更快、更准确地构建定制化的大语言模型,满足各行各业的不同需求。

空中批处理:现在广泛使用大型语言模型。

一个模型可以同时用于各种看似完全不同的任务——从聊天机器人中简单的问答响应,到文档摘要或长代码块的生成。工作负载是高度动态的,输出大小需要满足不同数量级任务的需要。

任务的多样性可能会使有效地批处理请求和高效地并行执行它们变得困难,并且可能会导致一些请求比其他请求更早完成。

为了管理这些动态负载,TensorRT-LLM包含了一种称为“动态批处理”的优化调度技术。

其核心原理是,一个大型语言模型的整个文本生成过程可以分解为模型上的多次执行迭代。

对于正在进行的批处理,TensorRT-LLM运行时将立即从批处理中释放已完成的序列,而不是等待整个批处理继续处理下一组请求。

当执行新请求时,前一批中未完成的其他请求仍在处理中。

动态批处理和额外的内核级优化可以提高GPU利用率,并将LLM在H100上的实际请求基准的吞吐量至少提高一倍。

TensorRT-LLM,使用FP 8的H100 Transformer Engine,还提供了一个名为H100 Transformer Engine的功能,可以有效降低大模型推理时的内存消耗和延迟。

因为LLM包含了数十亿的模型权重和激活函数,所以通常用FP16或BF16的值来训练和表示,每个值占用16位内存。

但在推理时,大部分模型都可以通过使用量化技术进行有效的低精度表达,比如8位甚至4位整数(INT8或INT4)。

量化是在不牺牲准确性的情况下降低模型权重和激活准确性的过程。使用较低的精度意味着每个参数较小,模型在GPU内存中占用的空较少。

这使得使用相同的硬件来推理更大的模型成为可能,同时在执行期间在内存操作上花费更少的时间。

通过H100 Transformer引擎技术和TensorRT-LLM的H100 GPU,用户可以轻松地将模型权重转换为新的FP8格式,并可以自动编译模型以利用优化的FP8内核。

而且这个过程不需要任何代码!H100引入的FP8数据格式使开发人员能够量化他们的模型,并在不降低模型准确性的情况下大大减少内存消耗。

与INT8或INT4等其他数据格式相比,FP8量化保留了更高的精度,并实现了最快的性能,也最便于实现。

如何获得TensorRT-LLMTensorRT-LLM虽然还没有正式发布,但是用户现在已经可以抢先体验了。

英威达还表示,TensorRT-LLM将很快整合到英伟达NeMo框架中。

该框架是英伟达不久前刚刚推出的AI Enterprise的一部分,为企业客户提供了一个安全、稳定、可管理的企业级AI软件平台。

开发人员和研究人员可以通过英伟达NGC上的NeMo框架或GitHub上的项目访问TensorRT-LLM。

不过需要注意的是,用户必须注册英伟达开发者计划才能申请抢先体验版。

Reddit上的网友对TensorRT-LLM的推出进行了热烈的讨论。

很难想象专门针对LLM优化硬件后效果会有多大提升。

但也有网友认为,这个东西的意义在于帮助老黄卖出更多H100。

不过,也有网友不太认同。他认为Tensor RT对本地部署SD的用户也有帮助,所以只要有RTX GPU,未来应该有可能受益于同类产品。

从更宏观的角度来看,或许对于LLM来说,会有一系列专门针对硬件层面的优化,甚至未来会出现专门为LLM设计的硬件来提升LLM的性能。这种情况其实在很多热门应用中都出现过,LLM也不例外。

温馨提示:注:内容来源均采集于互联网,不要轻信任何,后果自负,本站不承担任何责任。若本站收录的信息无意侵犯了贵司版权,请给我们来信,我们会及时处理和回复。

原文地址"英伟达开发版,英伟达开源驱动":http://www.ljycsb.cn/qukuailian/209002.html。

微信扫描二维码投放广告

▲长按图片识别二维码